Gần đây, Hội thảo về Thiết kế và Ứng dụng Công nghiệp Chip ô tô lần thứ ba của Đại học Tsinghua cùng Diễn đàn Cựu sinh viên đã diễn ra thành công tại Wuhu. Là khách mời đặc biệt của sự kiện này, Tiến sĩ Liang Shuang, đồng sáng lập và giám đốc điều hành của Super Star Future, đã tham dự và phát biểu với chủ đề “Tối ưu hóa hợp tác phần mềm và phần cứng, trao quyền cho kỷ nguyên AI 2.0”.

Mô hình lớn là “động cơ hơi nước” của kỷ nguyên AI 2.0

Ứng dụng AI+X và điện toán biên sẽ trở thành yếu tố then chốt

Kể từ khi ChatGPT ra mắt, mô hình lớn đã bùng nổ “Cách mạng Công nghiệp lần thứ tư”, trở thành “động cơ hơi nước” của kỷ nguyên AI 2.0, thúc đẩy sự biến đổi thông minh trong nhiều lĩnh vực. Paul Mantu đã từng nói: “Động cơ hơi nước không tạo ra công nghiệp lớn, nhưng nó cung cấp năng lượng cho công nghiệp lớn”, mô hình lớn cũng vậy, nó không trực tiếp tạo ra ngành công nghiệp mới, mà là kết hợp với các ứng dụng và dữ liệu trong ngành hiện có để tạo ra giá trị.

Sau sự kiện WAIC 2024, một số phương tiện truyền thông đã nhận định: không còn người chơi mới trong mô hình lớn, giai đoạn tiếp theo của AGI là tính toán và ứng dụng. Liang Shuang cho rằng, giai đoạn tiếp theo của AGI sẽ là việc triển khai ứng dụng AI+X và điện toán biên. Ở kỷ nguyên AI 1.0, mô hình mạng nơ-ron ở phía máy chủ dần dần thâm nhập vào các đầu cuối biên trong các lĩnh vực an ninh, lái xe thông minh, và xu hướng này chắc chắn sẽ được tái hiện trong kỷ nguyên AI 2.0, đồng thời tạo ra một thị trường gia tăng rộng lớn hơn trong các lĩnh vực như thành phố thông minh, ô tô, robot và điện tử tiêu dùng.

Nhìn lại lịch sử phát triển của AI, có thể thấy rằng mô hình chính trong kỷ nguyên AI 1.0 là hoàn thành nhiệm vụ đơn lẻ thông qua mô hình đơn lẻ, chẳng hạn như an ninh, nhận diện khuôn mặt, nhận diện giọng nói, và các giải pháp lái xe thông minh dựa trên cảm nhận-quyết định-kiểm soát theo các mô-đun. Liang Shuang cho rằng hiện nay chúng ta đang bước vào “kỷ nguyên AI 1.5”, trong đó các hệ thống phức tạp như lái xe thông minh và robot, sử dụng mạng nơ-ron thống nhất để hoàn thành tính năng của các mô-đun khác nhau, tối thiểu hóa quy tắc thủ công và nâng cao hiệu suất thông qua mô hình dựa trên dữ liệu, giảm đáng kể độ khó trong việc xử lý các vấn đề đa dạng. Trong kỷ nguyên AI 2.0, hệ thống sẽ được một mô hình lớn chung điển hình để đáp ứng đầu vào dữ liệu từ nhiều nguồn và hoàn thành nhiều nhiệm vụ phức tạp, mô hình nền tảng này cần phải có khả năng nhận thức mọi thứ, hiểu biết về kiến thức thông thường và hiểu khả năng suy luận, các mô hình nền tảng cho lái xe thông minh và robot về cơ bản là một loại mô hình nền tảng.

Từ cuối đến cuối và mô hình lớn đang được triển khai

Ô tô thông minh là giai đoạn cần thiết để tiến tới robot thông dụng

Trong những năm gần đây, hệ thống điều khiển thông minh đang dần nâng cấp từ cảm nhận CNN đơn lẻ truyền thống sang cảm nhận CNN BEV đa cảm biến, dựa trên mô hình BEV và giải pháp Occupancy dựa trên Transformer, và đang tiến tới mô hình lớn từ cuối đến cuối. Khi các bộ phận quy định và kiểm soát dần dần được mô hình hóa mà không có quy tắc can thiệp ở giữa, do đó dưới sự dẫn dắt của dữ liệu chất lượng cao khổng lồ, giới hạn hiệu suất sẽ được nâng cao đáng kể, đồng thời giảm tham gia của con người trong việc giải quyết các vấn đề đa dạng, giúp giảm tối đa lượng công việc lập trình phần mềm tới 99%. Hơn nữa, mô hình lớn về thị giác sẽ giúp hệ thống lái tự tăng cường khả năng hiểu biết về ngữ nghĩa phức tạp của thế giới vật lý, làm cho hành vi lái xe gần gũi hơn với con người, nâng cao khả năng xử lý các tình huống chưa biết.

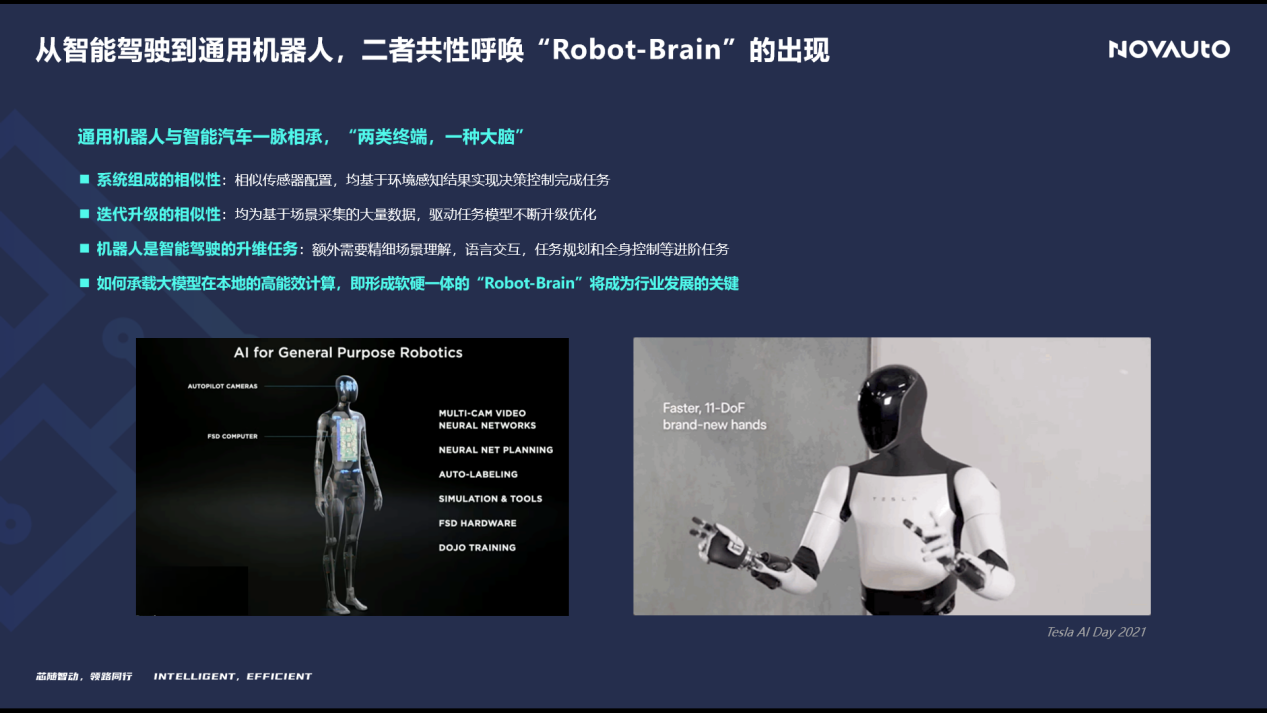

Liang Shuang chỉ ra rằng, ô tô thông minh sẽ là một giai đoạn cần thiết trong việc tiến tới robot thông dụng, ví dụ như robot Optimus của TESLA và ô tô thông minh đều sử dụng cùng nền tảng FSD, và có cấu hình hệ thống, nhiệm vụ chức năng tương tự nhau. Mặc dù cấu thành hệ thống và nâng cấp của hai bên rất giống nhau, nhưng chiều kích của robot cao hơn và nhiệm vụ phức tạp hơn, việc triển khai mô hình lớn vào các thiết bị ở phía biên sẽ tạo thành một “Bộ não Robot”, điều này sẽ trở thành yếu tố quyết định trong sự phát triển của ngành.

Tồn tại thách thức lớn trong việc triển khai mô hình lớn ở phía biên

Tối ưu hóa hợp tác phần mềm và phần cứng là con đường khả thi để triển khai

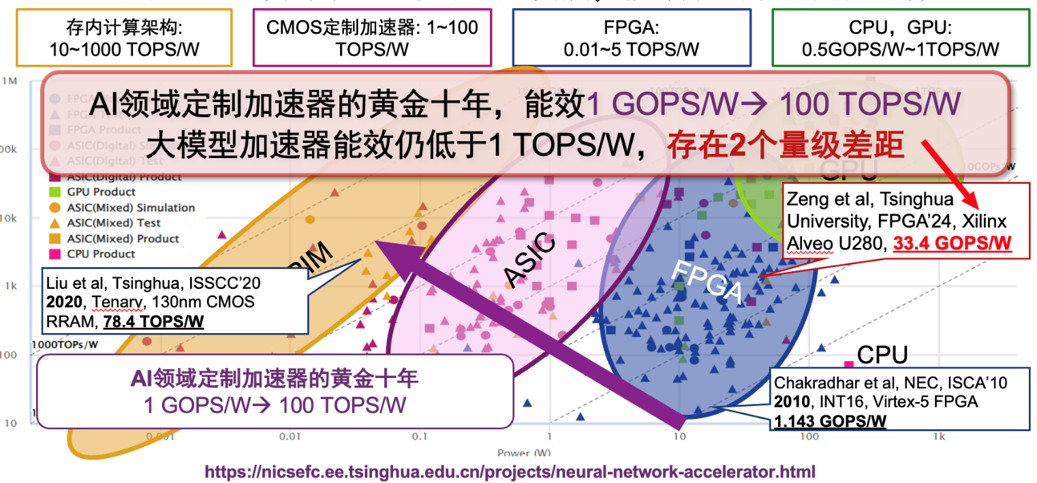

Mười năm qua được gọi là thập kỷ vàng của AI, mức năng suất của bộ gia tốc CNN đã tăng lên 100TOPS/W. Kích thước và tốc độ tăng trưởng tham số của mô hình lớn vượt xa thời kỳ CNN, vượt xa tốc độ tăng trưởng của phần cứng tính toán truyền thống. Tuy nhiên, hiệu suất năng lượng của các bộ xử lý mô hình lớn hiện tại vẫn nhỏ hơn 1TOPS/W, tạo ra một khoảng cách hai bậc so với nhu cầu ứng dụng phía biên, hạn chế nghiêm trọng khả năng triển khai của mô hình lớn.

Hiện tại, nhiều mô hình “nhỏ” được triển khai cục bộ trên điện thoại di động thuộc loại 2B, thường gặp các hạn chế về khả năng như mất thông tin lịch sử khi được áp dụng vào các tình huống phía biên, trong khi mô hình lớn với kích thước 7B trở lên có nhu cầu lớn hơn và hiệu ứng nâng cao đáng kể, thường khó triển khai vào các chip phía biên hiện có. Nguyên nhân chính bao gồm: (1) Sự thiếu hụt năng lực tính toán rõ rệt từ kiến trúc truyền thống, 50-80% nhu cầu năng lực tính toán trong các loại tính toán của lớp Attention trong mô hình lớn đều nằm trong các loại mat-xơ, và KV mẫu có tính chất thưa thớt rõ ràng, cần được hỗ trợ chuyên biệt; (2) Số lượng tham số và yêu cầu băng thông khổng lồ, mô hình điểm nổi tiếng cấp 7B chỉ cần không gian lưu trữ 28GByte, và tính của trọng số tương đối thấp, vì vậy quy trình xử lý tính toán của mô hình lớn cần thường xuyên đọc dữ liệu từ bộ nhớ ngoài, yêu cầu băng thông của mỗi Token sẽ lớn hơn 10GB/s; (3) Loại độ chính xác trong kiến trúc hiện tại không đủ, độ chính xác tính toán của mạng CNN truyền thống thường có thể sử dụng INT8 với hiệu quả tốt, trong khi các loại toán tử trong mô hình lớn sẽ cần hỗ trợ các loại tính toán với độ chính xác khác nhau như INT4/FP8/BF16 và các lớp kích hoạt, lớp chuẩn hóa có phạm vi động lớn, khiến nhiều thuật toán định lượng hiện có không thể hỗ trợ tốt.

Từ phương pháp nâng cao hiệu suất xử lý của mô hình lớn ở phía biên nhìn chung có hai hướng: một là nâng cao mức công nghệ giảm quy mô, nhưng do sự ảnh hưởng từ định luật Moore và tình hình quốc tế, rất khó để tiếp tục duy trì; hai là thông qua thiết bị và hệ thống mới, nhưng độ trưởng thành của ứng dụng vẫn cần nâng cao và hoàn thiện hơn về mặt công nghệ. Tuy nhiên, vào hiện tại, phương pháp khả thi nhất là tối ưu hóa hợp tác phần mềm và phần cứng cho các ứng dụng mô hình lớn, với phần mềm sử dụng phương pháp định lượng hỗn hợp mới và xử lý thưa thớt, còn phần cứng hướng tới thiết kế tăng tốc cho cấu trúc thuật toán phổ biến trong mô hình lớn, từ đó nâng cao hiệu suất năng lượng tổng thể từ 2-3 bậc.

Tối ưu hóa sâu cho các yêu cầu mới của nhiệm vụ mô hình lớn

Super Star Future dẫn đầu ngành tính toán AGI ở phía biên

Super Star Future chủ yếu hướng tới các loại cảnh thông minh ở phía biên, cung cấp các giải pháp tính toán hiệu năng cao dựa trên chip tính toán AI làm cốt lõi và bằng cách hợp tác chặt chẽ giữa phần mềm và phần cứng, nhằm trở thành người dẫn đầu trong tính toán AGI ở phía biên.

NPU “Bình Hồ/Gao Hạ”: Đội ngũ đã rèn giũa trong suốt mười năm, đạt được giới hạn hiệu suất trong ngành

Đối với các tác vụ tính toán mạng nơ-ron cần cho lái xe thông minh và mô hình lớn, Super Star Future đã tự phát triển các nhân xử lý AI hiệu suất cao “Bình Hồ” và “Gao Hạ”. NPU “Bình Hồ” chủ yếu cung cấp tính toán hiệu quả cho các tác vụ cảm nhận với CNN và một số ít Transformer, trong khi NPU “Gao Hạ” được thiết kế riêng để xử lý thời gian thực cho lái xe thông minh cao cấp và các mô hình lớn.

Trong đó, NPU “Bình Hồ” có độ trễ suy luận và tỷ lệ khung hình cho các mô hình CNN/Transformer chính thống đều ở mức dẫn đầu ngành, so với một số sản phẩm cạnh tranh được thị trường công nhận rộng rãi, tỷ lệ khung hình suy luận trên một đơn vị tính toán ở các tác vụ CNN tăng gấp 10 lần, các tác vụ Transformer tăng gấp 25 lần.

Kiến trúc NPU “Gao Hạ” sử dụng thiết kế tập lệnh với độ hạt hỗn hợp, mỗi cụm có thể đạt tới 40TOPS năng lực, hỗ trợ nhiều loại độ chính xác tính toán khác nhau như INT4/INT8/FP8/BF16, và tối ưu hóa trong thiết kế bộ đệm bên trong, thêm vào đó là cấu trúc tăng tốc chuyên dụng cho Sparse Attention và tích chập thưa ba chiều. Nhờ những thiết kế tối ưu này, NPU “Gao Hạ” hỗ trợ tính toán thời gian thực cho các mô hình lớn tạo sinh điển hình, tốc độ tạo sinh tối đa của LLaMA3-8B có thể đạt tới 60tokens/s. Hơn nữa, NPU “Gao Hạ” có thể thực hiện tốc độ xử lý tích chập thưa ba chiều gần như tương đương với 1% diện tích logic tính toán của chip NVIDIA Orin.

Chip “Kinh Sát”: Đã được triển khai hàng loạt trong nhiều lĩnh vực, sản phẩm mới nhất hỗ trợ tính toán thời gian thực cho mô hình lớn ở phía biên

Dựa trên nhân NPU tự phát triển, Super Star Future đã phát hành chip tính toán AI phía biên “Kinh Sát R1” vào cuối năm 2022, với khả năng xử lý NPU là 16TOPS@INT8, công suất tiêu thụ điển hình chỉ 7-8W, do đó có thể hỗ trợ thiết kế tản nhiệt tự nhiên cho các hệ thống. “Kinh Sát R1” hiện đã được triển khai hàng loạt trong các lĩnh vực ô tô, điện lực, khai thác than và robot.

Super Star Future cũng sắp phát hành chip thế hệ tiếp theo của series “Kinh Sát”, có khả năng thực hiện xử lý thời gian thực cho mô hình lớn, dưới quy trình 12nm sẽ đạt hiệu suất tương đương với các chip smartphone SOTA như Snapdragon 8Gen3 và Dimensity 9300. Theo lộ trình phát triển sản phẩm chip của Super Star Future, công ty sẽ tiếp tục duy trì khả năng mở rộng của ma trận sản phẩm, từ cảm nhận biên đến nâng cấp lái thông minh, tiến tới “Bộ não Robot” dần dần.

Công cụ triển khai mô hình “Lộ Bàn”: Tích hợp phương pháp tối ưu hóa mô hình lớn mới, hỗ trợ phần mềm hợp tác đạt được hiệu suất nâng cao gấp 40 lần

Dựa trên kiến trúc phần cứng hiệu quả, Super Star Future đã phát triển công cụ “Lộ Bàn” tối ưu hóa sâu cho ứng dụng mạng nơ-ron, có thể cải thiện tốc độ suy luận ở phía biên lên trên 40 lần, cụ thể bao gồm:

(1) Công cụ định lượng hỗn hợp dẫn đầu ngành, hỗ trợ chức năng PTQ/QAT/AWQ, hỗ trợ độ chính xác INT4/INT8/FP8/BF16, tổn thất định lượng dưới 1%;

(2) Công cụ tối ưu hóa mô hình hiệu quả, hỗ trợ phân tích độ nhạy, chưng cất, Lora, trong sự giảm thiểu tổn thất độ chính xác dưới 1%, tỷ lệ nén mô hình hơn 10 lần;

(3) Công cụ biên dịch hiệu suất cao, cung cấp công nghệ tối ưu hóa đồ thị tính toán phong phú và lập lịch lệnh hiệu quả hướng tới hạt nhân khác nhau, có thể nâng cao hiệu suất suy luận từ 4-5 lần trở lên.

Đặc biệt đối với nhiệm vụ mô hình lớn, “Lộ Bàn” thông qua phương pháp duy trì và định lượng hỗn hợp, có thể giảm bớt độ rộng trọng số xuống trung bình 2.8bit. Dựa trên phương pháp mặt nạ thưa thớt, có thể nén LLaMA3-8B tới hơn 90% trong khi vẫn giữ nguyên khả năng xử lý của mô hình, giảm đáng kể tham số và khối lượng tính toán của mô hình.

Nền tảng khép kín dữ liệu “Thao Khê”: Tự động hóa sản xuất dữ liệu, xây dựng vòng lặp cải tiến ứng dụng

Trong kỷ nguyên mô hình lớn, sự lặp lại thuật toán chất lượng cao cần các công cụ khép kín dữ liệu mạnh mẽ. Do đó, Super Star Future đã phát triển nền tảng “Thao Khê”, bao gồm quản lý dữ liệu, khai thác dữ liệu, tăng cường dữ liệu, sản xuất chân lý, sản xuất mô hình và đánh giá thuật toán, và đã ứng dụng mô hình lớn trong nhiều quy trình để cung cấp chức năng nâng cao.

Dựa trên nền tảng này, thông qua việc xây dựng quy trình hoàn chỉnh, khách hàng có thể thu thập dữ liệu có giá trị từ môi trường và giảm thiểu mức độ tham gia của con người, thực hiện khai thác và gán nhãn dữ liệu tự động để hỗ trợ khách hàng đạt được sự lặp lại của thuật toán dựa trên dữ liệu. Hiện tại, nền tảng “Thao Khê” đã cung cấp dịch vụ cho các nhà sản xuất ô tô, khách hàng Tier1, đồng thời mở rộng khả năng hỗ trợ cho khách hàng robot.

Tiến tới mục tiêu, bước nhanh về phía trước

Cung cấp giải pháp “AI+” hiệu quả cho khách hàng

Dựa trên hơn mười năm kinh nghiệm nghiên cứu và thực hành trong lĩnh vực AI, Super Star Future luôn theo sát con đường phát triển từ AI 1.0 đến AI 2.0, không ngừng hoàn thiện sản phẩm cốt lõi để hiện thực hóa ứng dụng AI+X.

Tại các cảnh ở phía biên, Super Star Future đã thực hiện các sản phẩm chip phân khúc an ninh đa dạng, như điện lực, khai thác than, thực hiện quy mô hóa doanh thu, đồng thời thông qua việc triển khai thực tế, liên tục cải tiến hệ sinh thái sản phẩm liên quan, hình thành hỗ trợ cho các hướng dài hạn như lái thông minh và AGI. “Trong bối cảnh thị trường hiện tại đầy thử thách, nhanh chóng hiện diện mới là con đường sinh tồn.”

Trong các cảnh lái thông minh, chip series “Kinh Sát” có thể hỗ trợ nhiều giải pháp lái thông minh đa chiều, như hệ thống toàn diện nhì viễn, các giải pháp hai viễn, hệ thống hành trình-đậu xe 5-7V giá hiệu quả cao, hệ thống hành trình-đậu xe hiệu suất cao 11V1L, bao gồm nhiều chức năng chủ yếu trong lái xe, đậu xe và lái thông minh cũng như robot. Các giải pháp tham khảo liên quan đã hoàn thành tối ưu hóa và kết nối trên xe. Hiện tại, Super Star Future đã hợp tác với một số nhà sản xuất xe thương mại hàng đầu trong ngành, đồng thời đạt được hợp tác kinh doanh với nhiều khách hàng ô tô du lịch, dự kiến sẽ triển khai hàng loạt từ năm 2025.

Trong các cảnh suy luận mô hình lớn ở phía biên, dựa trên khả năng tối ưu hóa hợp tác phần mềm và phần cứng của công cụ “Lộ Bàn”, sản phẩm chip mới nhất của Super Star Future đã thử nghiệm thực tế trên nền tảng chứng minh rằng ChatGLM-6B có thể đạt tốc độ tạo sinh vượt quá 15tokens/s, chip với quy mô 10W có thể hỗ trợ triển khai mô hình lớn hiệu suất cao ở phía biên; nền tảng NPU “Gao Hạ” phiên bản Stable Diffusion 1.5 có thể hoàn thành việc tạo hình ảnh trong thời gian 3.5s. Dựa trên các khả năng trên, Super Star Future đã hợp tác với các khách hàng robot hàng đầu trong ngành và các nhà sản xuất mô hình lớn.

Con đường dài, nhưng hành động sẽ đưa chúng ta đến đích

Cùng nhau xây dựng kỷ nguyên AI 2.0 mới

“Chúng ta thường đánh giá sai về sự phát triển công nghệ, thường là thấp hơn và chậm hơn. Khi sự phát triển công nghệ vượt qua ngưỡng nào đó, nó sẽ tăng trưởng bùng nổ, như từ sự phát hành ChatGPT đến cuộc chiến mô hình hiện nay. Dù là lái thông minh cấp cao hay ứng dụng robot thông dụng, chỉ cần mô hình công nghệ đúng, nguồn nhân lực và tài chính liên tục được đầu tư, ‘Khoảnh khắc ChatGPT’ chắc chắn sẽ đến, và thời điểm này có thể sẽ đến nhanh hơn chúng ta nghĩ.” Liang Shuang chia sẻ, “Super Star Future hy vọng hợp tác với tất cả các đối tác, từng bước tiến từ kỷ nguyên AI 1.0, cùng nhau xây dựng kỷ nguyên AI 2.0 mới.”